.svg)

C’est le texte dont tout le monde parle à Bruxelles et qui fait trembler les DSI. L’IA Act (ou Règlement Européen sur l’IA) est une réalité, et son calendrier d'application fixe une échéance majeure à l'été 2026.

Pour beaucoup de dirigeants de PME, ce règlement ressemble à une nouvelle montagne administrative, comparable au RGPD. La peur est légitime : est-ce que cela va freiner mon innovation ? Est-ce que je risque une amende si j'utilise ChatGPT ?

Chez Bloom, nous avons analysé le texte pour vous. La bonne nouvelle, c'est que l'IA Act est conçu selon une "approche par les risques". Contrairement au RGPD qui s'applique à toutes les données, l'IA Act ne s'abat pas sur tout le monde avec la même force.

Votre PME est-elle dans le viseur ? Voici le décryptage pour vous situer en 5 minutes.

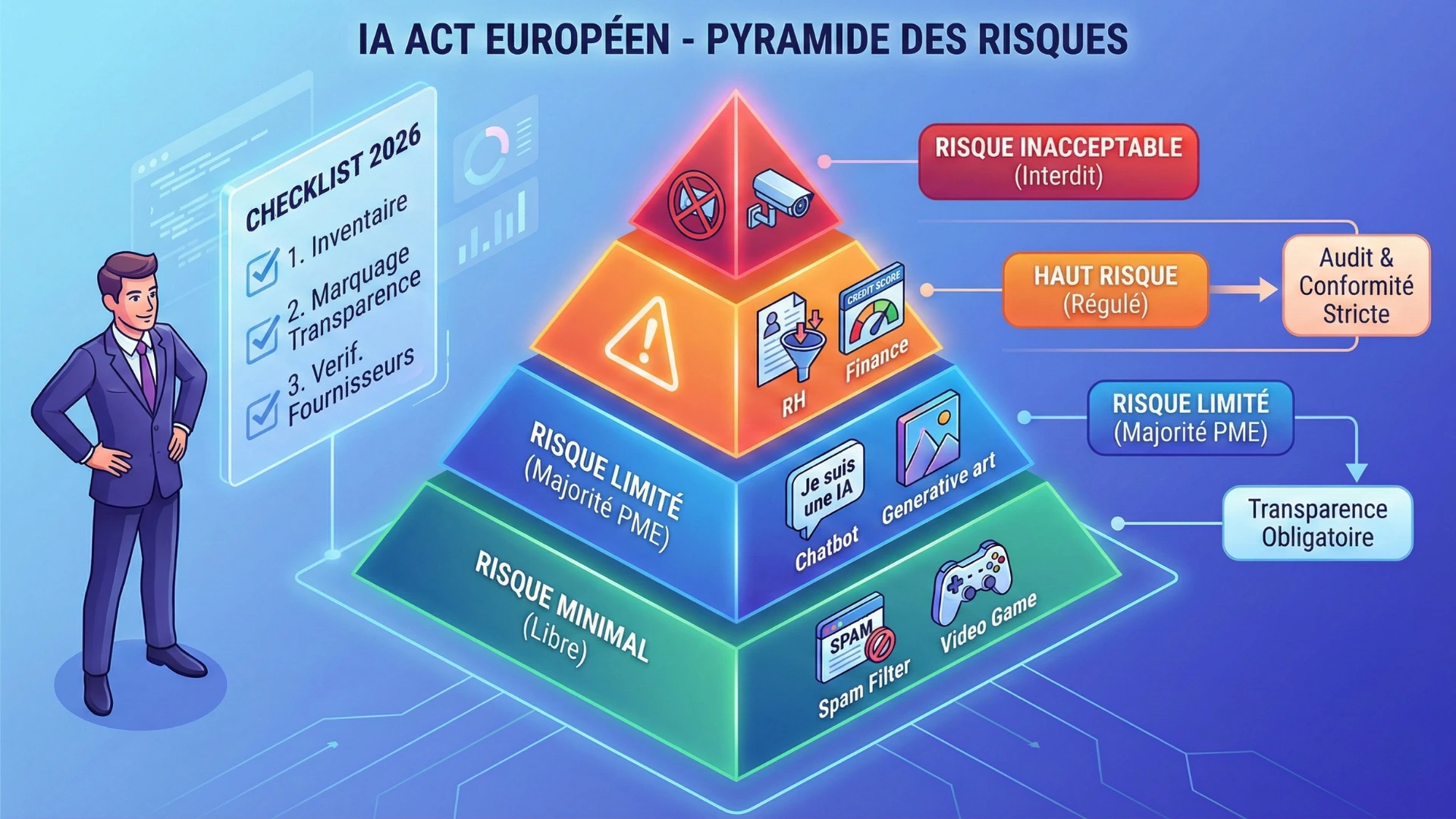

L'IA Act européen classe les systèmes d'intelligence artificielle en 4 niveaux de risque : inacceptable (interdit), haut risque (strictement régulé), risque limité (transparence obligatoire) et risque minimal (aucune obligation). Pour la majorité des PME utilisant des outils standards (chatbots, aide à la rédaction), seules les règles de transparence s'appliquent, notamment l'obligation d'informer l'utilisateur qu'il interagit avec une machine.

Imaginez une pyramide à 4 étages. Votre niveau d'obligation dépend de l'étage où se situent vos outils.

C'est simple : ces usages sont bannis en Europe.

C'est ici que se joue la conformité lourde (marquage CE, audit, contrôle humain). Cela concerne les IA qui impactent la vie, la sécurité ou les droits fondamentaux des gens.

C'est le cas le plus fréquent pour une PME qui digitalise sa relation client.

Tout le reste.

C'est la question centrale. Si vous développez ou utilisez un système classé "Haut Risque", vous devez être prêts pour l'échéance de mi-2026.

Si vous utilisez une plateforme de recrutement innovante qui promet de "trouver les meilleurs profils grâce à l'IA", attention. Si l'IA classe, note ou élimine des candidats, c'est du Haut Risque.

Vous devez vous assurer que l'outil est certifié, que les données d'entraînement ne sont pas biaisées (ex: discrimination femmes/hommes) et qu'un humain valide toujours la décision finale. C'est un point clé à intégrer dans votre gouvernance IA entreprise globale.

Si vous entraînez votre propre modèle sur des données moissonnées sur le web, vous entrez dans des obligations complexes liées aux droits d'auteur. Mais rassurez-vous, 99% des PME utilisent des modèles existants (GPT-4, Claude, Mistral) et ne sont pas concernées par cette couche "fournisseur de modèle" (GPAI).

Pour dormir tranquille, voici les 4 actions à mener dès maintenant pour anticiper l'échéance.

Faites la liste de toutes les IA utilisées chez vous. N'oubliez pas les outils "gratuits" utilisés par vos équipes marketing ou dev. Vous ne pouvez pas conformer ce que vous ne connaissez pas.

Si vous avez mis en place un chatbot de support client, ajoutez immédiatement la mention : "Je suis un assistant virtuel piloté par une IA".

Si vous utilisez l'IA pour générer des images ou des voix synthétiques (pour une pub par exemple), indiquez clairement l'origine artificielle du contenu. C'est une obligation légale, mais aussi un gage de confiance pour vos clients.

Vous n'êtes pas Google, vous n'avez pas codé l'IA. Mais si vous l'utilisez, vous êtes responsable.

Contactez vos éditeurs de logiciels (ATS, CRM, ERP) et posez la question : "Votre module IA est-il conforme à l'IA Act ?". Exigez des garanties écrites, surtout si l'outil touche aux RH ou aux données financières. Attention, la mise en conformité peut avoir un coût (audits, changement d'outils). Pensez à vérifier les aides disponibles pour financer sa stratégie IA et absorber ces coûts réglementaires sans impacter votre trésorerie

L'IA Act impose une "littératie IA" (compétence) pour les entreprises utilisatrices. Vos employés doivent comprendre comment fonctionnent les systèmes qu'ils utilisent pour repérer une erreur ou un biais. C'est là qu'intervient une démarche structurée d'acculturation IA pour l'ensemble des collaborateurs.

Ne voyez pas l'IA Act comme un frein. En 2026, afficher que vos systèmes sont conformes, transparents et supervisés deviendra un argument commercial puissant.

Dans un monde où les deepfakes et les fausses informations pullulent, être une PME "IA Responsable" rassurera vos grands donneurs d'ordres et vos clients finaux.

Vous avez un doute sur la classification de votre projet IA ?

N'attendez pas la sanction. Lors d'un call de cadrage, nous pouvons rapidement identifier si vos cas d'usage tombent dans la zone de vigilance et comment les sécuriser.

Expliquez-nous vos objectifs, nous vous guiderons vers la formation IA la plus adaptée.

.svg)

Formations IA concrètes et mesurables pour PME et ETI françaises. Gagnez en productivité avec l'intelligence artificielle.