.svg)

Pendant deux ans, la course à l'IA a ressemblé à une course au gigantisme. C'était à qui aurait le plus gros modèle, le plus grand nombre de paramètres, la plus grande base de données d'entraînement. Nous avons cru que, pour être intelligente, une IA devait avoir lu tout Internet.

En 2026, le vent tourne. Les géants de la Tech (Microsoft, Google, Mistral) misent désormais sur les Small Language Models (SLM). Ces modèles légers s'imposent comme une des tendances IA entreprise 2026 majeures, marquant le passage de l'expérimentation à l'industrialisation sobre.

Pourquoi ce revirement ? Parce que pour une PME, utiliser un modèle géant comme GPT-4 pour résumer une réunion, c'est comme louer un Airbus A380 pour aller acheter du pain. C'est possible, mais c'est cher, lent et disproportionné.

Voici pourquoi votre future stratégie IA passera probablement par le "Small" pour gagner en sécurité et en rentabilité.

Une définition SLM entreprise (Small Language Model) désigne une catégorie de modèles d'intelligence artificielle comportant moins de paramètres (généralement quelques milliards contre des centaines pour les LLM). Conçus pour être légers, ils offrent aux entreprises trois avantages majeurs : ils peuvent fonctionner en local (confidentialité des données), ils consomment peu d'énergie (coût réduit) et sont excellents sur des tâches spécifiques une fois entraînés sur les données métier.

Pour comprendre l'intérêt des SLM, il faut saisir la différence d'architecture avec les LLM (Large Language Models) que vous utilisez peut-être déjà via ChatGPT.

Les LLM sont des généralistes. Ils savent écrire un poème, coder en Python et expliquer la physique quantique. Pour réussir cet exploit, ils nécessitent une puissance de calcul phénoménale hébergée dans des datacenters géants. Ils sont parfaits pour la créativité ou les tâches nécessitant une culture encyclopédique.

Les SLM (comme Phi-3, Gemma ou Mistral-7B) sont des modèles optimisés. Ils ont "moins de culture générale", mais une capacité de raisonnement intacte.

Imaginez la différence entre une encyclopédie universelle et un manuel technique précis. Si votre besoin est de traiter des factures ou de répondre à des questions RH, le manuel technique (SLM) est plus rapide et suffit amplement.

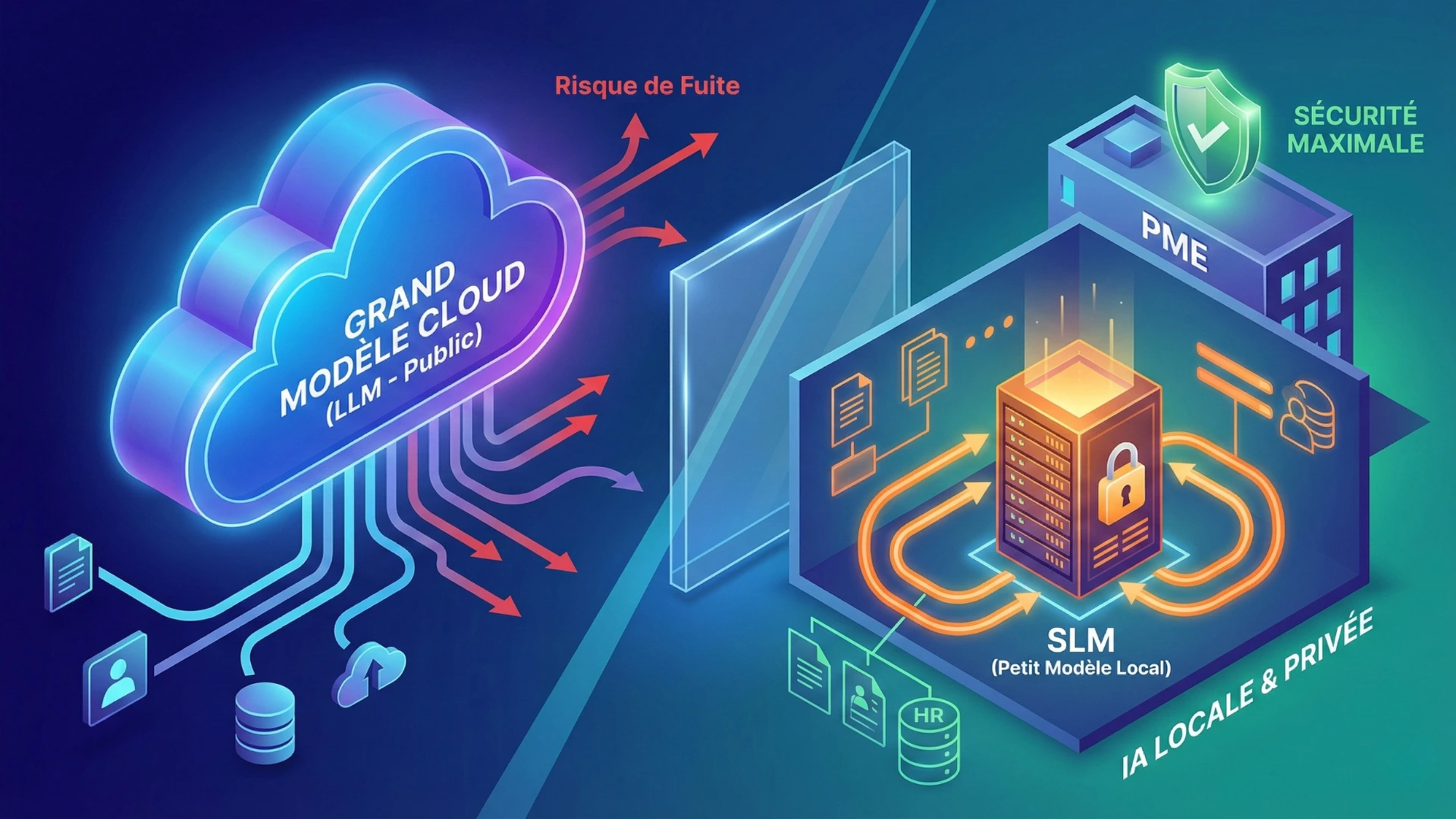

C'est l'argument qui convainc les DSI et les dirigeants soucieux de leur gouvernance IA entreprise. Avec les modèles géants, la confidentialité est toujours un défi.

Lorsque vous utilisez une API classique vers un gros modèle, vos données transitent souvent vers des serveurs externes (souvent américains). Même avec des garanties contractuelles, cela reste un frein bloquant pour les données sensibles (santé, juridique, secrets industriels, données personnelles).

Les SLM sont si légers qu'ils peuvent être installés en local.

Concrètement, ils tournent sur vos propres serveurs sécurisés ou même directement sur les ordinateurs portables de vos collaborateurs, sans connexion internet requise. Résultat : Vos données ne quittent jamais l'enceinte de l'entreprise. Le risque de fuite vers un tiers devient nul.

L'IA a un coût caché dont on parle peu : l'inférence (le coût de calcul de chaque réponse générée).

Interroger un modèle géant coûte cher en électricité et en abonnement. Pour une PME qui souhaite automatiser des milliers de tâches par jour (ex: trier des emails entrants), la facture peut vite exploser. Les SLM consomment 10 à 50 fois moins de ressources, rendant l'automatisation massive enfin rentable.

Parce qu'ils sont petits, les SLM "réfléchissent" plus vite. Ils permettent d'obtenir des réponses quasi instantanées. C'est un critère indispensable si vous souhaitez intégrer l'IA dans un chatbot de service client ou un système de commande vocale où l'utilisateur n'acceptera pas d'attendre 5 secondes une réponse.

Loin de la théorie, voici des exemples concrets où le SLM surpasse le LLM grâce à sa spécialisation .

Imaginez un assistant capable de répondre aux questions des salariés sur les congés, la mutuelle ou les fiches de paie. Un SLM entraîné sur vos documents internes peut le faire parfaitement, en garantissant que ces données RH confidentielles ne sortent jamais du réseau de l'entreprise.

Pour un cabinet comptable ou juridique, un SLM peut lire, classer et extraire les données de milliers de contrats ou de factures directement sur le serveur local. C'est un des cas d'usage IA les plus rentables, car il supprime la saisie manuelle sans exposer les données clients.

L'avenir de l'IA en entreprise n'est pas monolithique. Il sera hybride.

Vous continuerez probablement à utiliser des modèles géants pour la créativité ou les tâches très complexes. Mais pour les processus métiers quotidiens, répétitifs et sensibles, les SLM vont s'imposer comme le standard.

Ils marquent le passage d'une IA "gadget magique" à une IA "outil industriel" : fiable, privée et rentable.

Vous ne savez pas quel modèle choisir pour votre projet ?

Le choix entre LLM et SLM dépend de votre cas d'usage et de vos contraintes de sécurité. Lors d'un call de cadrage, nous vous aidons à définir l'architecture technique la plus adaptée à votre PME.

Expliquez-nous vos objectifs, nous vous guiderons vers la formation IA la plus adaptée.

.svg)

Formations IA concrètes et mesurables pour PME et ETI françaises. Gagnez en productivité avec l'intelligence artificielle.